Realtime Performance Capture in Videospielen und dessen mögliche Verwendung in den Darstellenden Künsten

Darstellende Kunst 4.0

Übersicht

Autor:

Marcel Klein

Akteur:innen:

Nils Corte, Laura Herzing, Alexander Kerlin, Tina Lorenz, Eadweard Muybridge, Roman Renkl, Kay Voges, Kevin Xie, et. al.

"Was ist 'Realtime Performance Capture'?" - "Hat das nicht was mit Film zu tun?!" - "'Darstellende Kunst 4.0?' Ich kenn nur 'Industrie 4.0'." - Diese und ähnliche Fragen mögen sich beim Lesen des Titels dieses Artikels stellen. Ich möchte hiermit einen Überblick über aktuelle Entwicklungsstände im Bereich Motion Capture geben, exemplarisch aufzeigen, wie diese Technik in Videospielen bereits Anwendung findet und was sie für die Darstellende Kunst bedeuten könnte.

Marcel Klein, (2022) SAE Institute Munich

Den meisten Leser*innen dieses Artikels wird wohl nur die "Mutter" des Realtime Performance Capturings ein Begriff sein: Das Motion Capturing. Bekannt vor allem durch den Einsatz in Filmen wie "Toy Story", "Herr der Ringe", oder zuletzt "Alita - Battle Angel", erlangt Motion Capture eine immer größere Bedeutung in den modernen Medien. So auch in der Videospielbranche. Spieletitel wie “Beyond: Two Souls”, "Star Wars Jedi: Fallen Order", "Hellblade: Senua's Sacrifice" oder "Detroit Become Human" zeigen, was in diesem Bereich bereits möglich ist: Das in Echtzeit digitale Aufzeichnen von Mimik, Gestik, Stimme und Körperbewegung einer Person und die ebenfalls in Echtzeit Darstellung dessen in einer virtuellen Umgebung. Sprich: Performance Capture. Der Unterschied liegt also in der Aufzeichnung von entweder "Motion", nur Bewegung, oder "Performance", was Gestik, Mimik und Bewegung einschließt. Durch diese Weiterentwicklung wird Performance Capturing auch für die Darstellende Kunst interessant. Denn dort wurde in den letzten Jahren, vor allem bedingt durch die Corona-Pandemie, viel unternommen, um mit der ständig voranschreitenden Digitalisierung Schritt zu halten und "Digitale Performances" abseits des klassischen Sprech-, Musik- oder Tanztheaters auf die Bühne zu bringen. Dieser Artikel untersucht deshalb, welche Möglichkeiten sich mit Performance Capture für die Darstellenden Künste im Rahmen der Digitalisierung bieten. Wie also eine "Darstellende Kunst 4.0" in Analogie zur "Industrie 4.0" aussehen kann.

Was ist "Darstellende Kunst 4.0"?

"Die Wirtschaft steht an der Schwelle zur vierten industriellen Revolution. Durch das Internet getrieben, wachsen reale und virtuelle Welt zu einem Internet der Dinge zusammen." So beschreibt das Bundesministerium für Bildung und Forschung ihr Projekt "Industrie 4.0", mit dem es die deutsche Industrie für die Zukunft vorbereiten möchte. Für den Kulturbereich ist ein solches Projekt bisher nicht klar formuliert, angesichts der in allen Bereich des täglichen Lebens voranschreitenden Digitalisierung aber eigentlich dringend notwendig. Die Corona-Pandemie hat gerade dem Kulturbereich gezeigt, wie wichtig es ist, sich mit den modernen Medien auseinanderzusetzen und über die ungenutzten Möglichkeiten zu sprechen, die in der Aneignung digitaler Inhalte für alle Bereiche der Darstellenden Künste liegen. Obwohl auch im Koalitionsvertrag der neuen Bundesregierung keine konkreten Pläne zur Umsetzung einer Digitalisierung im Kulturbereich beschrieben sind, finden sich in unzähligen kleineren und größeren Projekten der freien und staatlich geförderten Kulturszene Ansätze diese Revolution anzugehen. Ich möchte auf ein paar dieser Ansätze im Folgenden eingehen. Ich möchte klar machen, in welche Richtung diese Revolution geht und warum meiner Ansicht nach in der Performance Capture Technologie eine noch zu selten genutzte Bereicherung für die Darstellenden Kunst liegen kann.

Beispiele für "Darstellende Kunst 4.0"

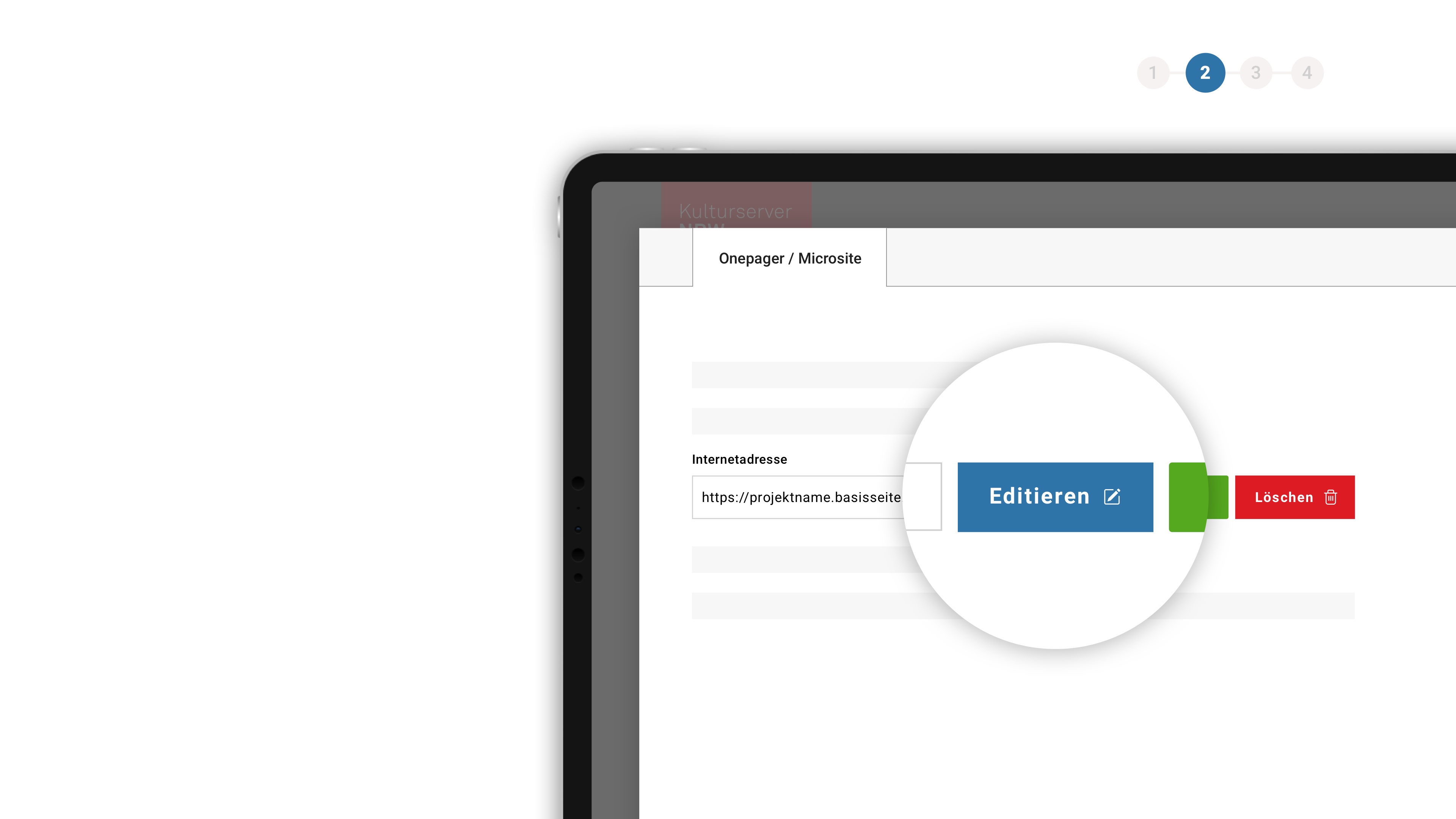

Die Akademie für Theater und Digitalität in Dortmund ist ein Beispiel der letzten Jahre einer innovativen Lösung für fehlende Forschung im Bereich der Digitalisierung des Kulturbereichs. Auf Initiative des damaligen Dortmunder Theaterintendanten Kay Voges und des Dramaturgen Alexander Kerlin wurde die Akademie 2018 gegründet, um folgende Fragen zu beantworten:

"Welches Know-How brauchen Theaterschaffende jetzt? Und welches in der Zukunft? Welche Werkzeuge können und müssen die Theater selbst entwickeln? Für welche Berufsfelder der Darstellenden Kunst müssen wir als technikaffine Kunstschaffende neue Möglichkeiten der Weiterbildung anbieten? Welche neuen Möglichkeiten der Narration ziehen in das Theater ein, katalysiert durch neue Technologien? Welche gesellschaftlichen Debatten können in den Theatern durch die Anwendung digitaler Technologien aufgegriffen oder sogar angestoßen werden? Was sind die Themen der Digitalen Moderne? Wie lässt sich Technologie – als Mittel der Herstellung und Gegenstand der Betrachtung – in einem künstlerischen Möglichkeitraum sinnlich erfahren und diskutieren?" (Akademie für Theater und Digitalität, 2022)

Zunächst auf Weiterbildungen für handwerklich-künstlerische und technisch-künstlerische Mitar- beiter*innen an Theatern beschränkt, hat die Akademie mittlerweile über sechs Jahrgänge von Fellowship-Programmen hinweg auch für freischaffende Künstler*innen eine Forschungsplattform geschaffen.

In eben diesem Fellowship-Programm hat sich 2020 das Künstlerkollektiv “minuseins” um Roman Senkl und Nils Corte mit Möglichkeiten von VR-Räumen für das Theater auseinandergesetzt. Dabei ist im Rahmen der Jahrestagung der Dramaturgischen Gesellschaft 2021 ein digitaler Begegnungsraum über die Browser-App Mozilla Hubs geschaffen und von einem Großteil der Beteiligten als eine echte Alternative zur Präsenzveranstaltung empfunden worden. Davon ausgehend beschäftigt sich das Kollektiv mit folgenden Fragen:

"Wie lässt sich Interaktion zwischen Publikum, Performer:in und virtueller Bühne realisieren? Wie gestalte ich den Raum und welcher Methoden bediene ich mich – klassische Dramaturgie oder Game Theory? Wie transformiere ich den Ausdruck der Performer:innen ins Digitale? Derzeit forschen und entwickeln wir insbesondere daran, wie mit Motion Capturing die Bewegungen der Performer:innen und mittels Facial Capturing deren Mimik auf virtuelle Avatare übertragen werden können." (Corte, 2022 auf nachtkritik.de)

Die erste deutsche Digitaltheatersparte des Staatstheaters Augsburg um die Leiterin Tina Lorenz hebt diesen Gedanken der Transformation des darstellerischen Ausdrucks ins Digitale auf die etablierte Staatstheaterbühne und schafft somit eine große Präsenz für dieses wichtige Thema. Ihr Anliegen ist es:

"[...] das Spielen auf digitalen Bühnen [...], mit hybriden Produktionen, die den physischen Bühnenraum mit dem virtuellen verbinden [...]" zu erforschen. (Staatstheater Augsburg, 2022)

Auch hier spielt der VR-Raum eine wichtige Rolle. Mit "vr-theater@home" wirbt die Sparte: "Erleben Sie Theater in einer neuen Dimension! Bei uns können Sie eigens für die 360-Grad-Perspektive geschaffene Inszenierungen samt der nötigen VR-Brille zu sich nach Hause bestellen."

Warum erwähne ich diese Beispiele? Es geht mir darum aufzuzeigen, womit die Darstellende Kunst mit dem Beginn der Digitalisierung zu kämpfen hat. Nämlich dem Alleinstellungsmerkmal der darstellenden Kunst an sich: Dem Live-Moment auf der Bühne, der einzigartig und jedes Mal anders ist. Um diesen nicht zu verlieren, finde ich es wichtig, sich mit dem Aspekt des Motion Capturings und des Performance Capturings zu befassen. Denn gerade diese Technologie könnte es ermöglichen, den einzigartigen, live stattfindenden Ausdruck des Darstellers oder der Darstellerin in Echtzeit in eine AR- oder VR-Umgebung zu übertragen und damit einmalig für die besuchenden Zuschauer zu machen.

Weitere Informationen zu Theater 4.0:

Heinrich-Böll Stiftung - Netztheater: www.boell.de/de/netztheater

Akademie für Theater und Digitalität: https://theater.digital wiki.theater.digital

Digitaltheater Augsburg: www.staatstheater-augsburg.de/digitaltheater_21

Theaterakademie August-Everding Zukunftskonferenz: www.theaterakademie.de/zukunftskonferenz

XR HUB Bavaria: www.xrhub-bavaria.de/category/feuilleton

Was ist also “Realtime Performance Capture”?

Um sich mit “Realtime Performance Capture” befassen zu können, muss man sich zum einen mit dessen Ursprung, also dem “Motion Capture” und zum anderen mit Beispielen aus der Videospielbranche auseinandersetzen, weil gerade hier viel Pionierarbeit geleistet wurde.

Motion Capture - Ein kurzer Überblick

Die Anfänge des Motion Capturings gehen zurück auf das Jahr 1879 und zu Eadweard Muybridge (1830–1904), Landschaftsfotograf in Kalifornien. Er erfand das “Zoopraxiscope”, das erste Motion-Picture-Gerät zum sequentiellen Fotografieren von Bewegungsabläufen, anfangs von Tieren und später auch von Menschen. Mit Beginn der 1980er Jahre kamen dann die ersten digitalen Versuche auf, Bewegungsabläufe einzufangen. Erst im Bereich der medizinischen und militärischen Anwendung und später auch in der Unterhaltungsbranche. So kam mit “FX Fighter” 1995 das erste Videospiel auf den Markt, das mithilfe von Motion Capture versuchte seinen digital erstellten Spielcharakteren einen realistischeren Bewegungsablauf zu geben.

Seitdem hat sich durch den technologischen Fortschritt, vor allem im Bereich der Grafikprozessoren, viel getan und mittlerweile lässt sich die Motion-Capture-Technologie in folgende Bereiche unterteilen:

Markerbasierte Systeme

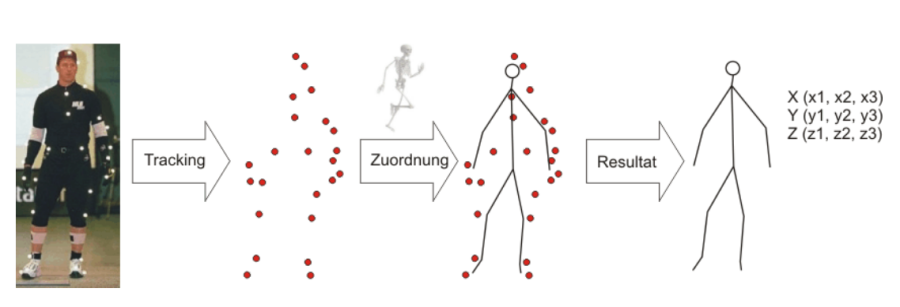

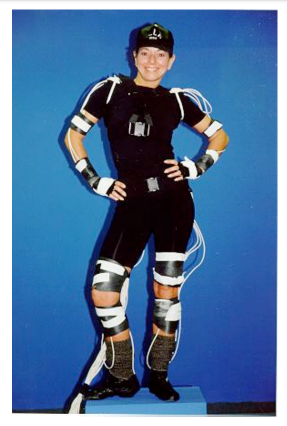

Markerbasierte Systeme bestehen in der Regel aus einer gewissen Anzahl spezieller reflektierender oder selbst leuchtender Markierungen, Markern genannt, die an den Bodysuit oder das Gesicht des*der Darsteller*in angebracht sind und einem Computer, der entweder die eingehenden Daten für die Weiterverarbeitung speichert oder gleich in eine virtuelle Umgebung einarbeitet.

Diese Technik wird weiter eingeteilt in verschiedene Arten wie diese Marker oder Sensoren ihre Bewegungsdaten aufnehmen und verarbeiten:

Optische Systeme

Bei dieser Art des Motion Capturings werden die Bewegungsdaten mithilfe von speziellen Kameras aufgezeichnet. Sie ist die am weitesten verbreitete Technik zum Aufzeichnen von Bewegungsabläufen.

Vorteile:

- Sehr genaue Datenaufzeichnung

- Mehrere Objekte gleichzeitig erfassbar

- Ermöglicht Erfassung auch in großen Räumen

Nachteile:

- Echtzeit-Übertragung in virtuelle Umgebung schwierig

- Hohe Nachbearbeitungszeit

- Marker können sich überdecken

- Hohe Kosten

Elektromagnetische Systeme

Hierbei werden keine Marker auf den zu erfassenden Objekten angebracht, sondern Sensoren, deren räumliche Position direkt von einem magnetischen Transmitter empfangen wird. Es werden also keine Kameras hierfür benötigt.

Vorteile:

- Keine Nachbearbeitungszeit

- Einfache Echtzeit-Übertragung

- Keine Überlagerung der Sensoren durch nichtmetallische Objekte

- Geringe Kosten

Nachteile:

- Kabelgebundenheit schränkt Bewegungsspielraum ein

- Ungenauere Datenaufzeichnung

- Erfassung nur in kleineren Räumen möglich

- Keine Aufzeichnung der Mimik möglich

Mechanische Systeme

Auch hier werden keine Kameras benötigt, denn bei mechanischen MoCap-Systemen wird den Objekten ein Exoskelett bestehend aus Potentiometern und Winkelmessern angelegt.

Bei diesem Ansatz werden die Winkel der Gelenke aufgenommen, indem parallel zu den Gliedmaßen mechanische Strukturen befestigt werden, sodass diese sich bei jeder Bewegung mitbewegen.

Vorteile:

- Keine Nachbearbeitungszeit

- Einfache Echtzeit-Übertragung

- Keine Interferenzen durch elektrische oder magnetische Signale

- Geringe Kosten

- Mobiles System

Nachteile:

- Keine globale Positionsbestimmung der Objekte

- Eingeschränkte Bewegungsfreiheit

- Keine dynamische Kalibrierung der Sensoren möglich

- Keine Aufzeichnung der Mimik möglich

Weitere MoCap-Systeme

Volumetric Capture

Bei diesem System werden nicht mehr einzelne Objekte erfasst, sondern ein ganzer Raum. Hierbei wird, ebenfalls mit Kameras, der Raum in einer Wolke aus volumetrischen Pixels aufgezeichnet.

Inertial Motion Capture

Ähnlich wie bei magnetischen Systemen werden hier gyroskopische Inertialsensoren genutzt, um auch ohne Kameras eine Aufzeichnung der Bewegungsdaten zu erreichen.

Computer Vision Based Capture

Für diese Art des Motion Capturings werden keine Marker mehr benötigt. Lediglich kontrollierte Lichtverhältnisse und eine gewisse Anzahl an Kameras werden zum Aufzeichnen der Bewegungen benötigt. Den Rest übernehmen Algorithmen, die darauf spezialisiert sind die eingehenden Daten der Kameras in Echtzeit umzuwandeln und in manchen Fällen eine KI (Künstliche Intelligenz), die durch den Input an Daten dazu lernt und Bewegung vorhersehen und dadurch flüssiger digitalisieren kann. Ein frühes Beispiel hierfür ist die von Microsoft 2010 zu Unterhaltungszwecken eingeführte Kinect-Kamera.

Anbieter für MoCap-Systeme:

Vicon: “We have revolutionized the motion capture industry for over 35 years, by pioneering a range of technologies – from optical to inertial and VR – to allow our customers to capture and analyze motion of all kinds.” www.vicon.com

XSens: “Xsens is the leading innovator in 3D motion tracking technology and products. Our sensor fusion technologies enable a seamless interaction between the physical and the digital world in consumer electronics devices and professional applications such as Motion Capture, Motion Analysis, healthcare, sports and industrial applications.” www.xsens.com

OptiTrack: “OptiTrack™ is the largest motion capture provider in the world, offering high-performance optical tracking at the most affordable prices in the industry. The OptiTrack product line includes motion capture software and high-speed tracking cameras, as well as contract engineering services. Used by facilities worldwide in a variety of markets ranging from film and games to sports training and biomechanics, OptiTrack customers include the top in their respective fields.” www.optitrack.com

Realtime Performance Capture

Bei diesem Motion Capture System, sollen nicht nur Bewegungsabläufe der äußeren Extremitäten erfasst werden, sondern auch die Mimik und Stimme, letzten Endes also wie der Name sagt, die gesamte Performance des*der Darsteller*in. Wie in Abbildung 7 zu sehen ist, geschieht das z.B. wie im Fall des Films “Alita: Battle Angel” aus dem Jahr 2019 über spezielle Helmvorrichtungen.

Außerdem sollen diese Daten nun nicht mehr nur aufgezeichnet werden und später verarbeitet werden, sondern in Echtzeit in die vorgefertigte virtuelle Umgebung eingearbeitet werden, sodass dem*der Regisseur*in wie in Abbildung 7 zu sehen ist, ein live gerendertes Video der Szene am Set zur Verfügung steht. Damit das möglich ist, werden verschiedene Mo-Cap-Systeme kombiniert. Laura Herzing, Executive Producer bei “Silver Spoon”, einem Animationsstudio aus New York, beschreibt diese Entwicklung wie folgt:

“With virtual production we’re transforming into less of a strict ‘motion capture studio’ and more of a ‘real time animation studio’.” (Laura Herzing, 2021, “A 2025 VISION PAPER” , Vicon)

Um Realtime Performance Capture auch im Hinblick auf eine mögliche Verwendung in den Darstellenden Künsten besser zu verstehen, möchte ich nun auf einige Beispiele aus der Videospielbranche eingehen.

Beispiele für “Performance Capture”

Hellblade: Senua’s Sacrifice (2017)

Mit “Hellblade: Senua’s Sacrifice” wollten das britische Entwicklerstudio “Ninja Theory” und das Softwareunternehmen bzw. Unreal-Engine-Entwickler “Epic Games” als Erste zeigen, wie man mit den Mitteln der Unreal Engine 4, einer Spiele- entwicklungssoftware, live gefilmte Performances in Echtzeit in eine virtuelle Welt übertragen und verändern kann. Mit einer recht kurzen Planungsphase von 7 Wochen wurde alles von der Idee bis zur Umsetzung auf die Beine gestellt. Am Ende entstand eine Kooperation aus folgenden Firmen: Ninja Theory, Epic Games, 3Lateral (Gesichtserkennung), Qubic Motion (Animation), IKinema (Motion Capture System), XSense (Motion Capture System).

Wie man in dieser Abbildung gut erkennen kann, werden hier optische Motion Capture Systeme zum Aufzeichnen der Bewegung eingesetzt und ein Helm mit weiteren Kameras am Kopf der Performerin angebracht, um die Mimik einzufangen. Es war die Zusammenarbeit zwischen “Cubic Motion” und “3Lateral”, die die detailreiche Mimik der virtuellen Figur hervorbrachte. Antoniades, Creative Director bei “Ninja Theory” beschreibt die Arbeit wie folgt:

"It was just unproven at the time, and we were the guinea pigs. But it worked beautifully. The detail was just incredible." (T. Antoniades, N. Summers, Engadget, 2017)

“Cubic Motion” kümmerte sich um ein auf Computer-Vision basierendes Facial-Tracking-System und kombiniertes es mit dem von “3Lateral” erstellten Rig, dem virtuellen Ebenbild der Performerin. Zusammen mit “Epic Games” und der “Unreal Engine 4” wurde anschließend eine Echtzeitübertragung der Daten in die virtuelle Welt möglich gemacht.

Detroit Become Human (2020)

Das Pariser Entwicklerstudio “Quantic Dream” benutzte für sein Videospiel “Detroit Become Human” ein optisches MoCap System das alleine auf der Computer-Vision-Technologie beruht. Mittlerweile lassen sich damit synchron Stimme, sowie Bewegungs- und Mimikdaten aufzeichnen und direkt in die virtuelle Welt übertragen. Das Team um C.E.O. David Cage hat das Facial-Tracking soweit perfektioniert, dass kein aufwendiges und den*die Performer*in einschränkendes Headset benötigt wird, was nach eigener Aussage ihr Studio zu einem der größten und technologisch höchst entwickelten Motion Capture Studios Europas macht.

Ausblick für Performance Capture

AI (Artificial Intelligence) Motion Capture

Forscher von “NVIDIA”, der “University of Toronto”, und dem “Vector Institute” in den USA haben 2021 ein Paper zu einer neuen Technologie heraus- gebracht, die die zuvor erwähnte Möglichkeit KI gestützte, videobasierte Motion Capture zu benutzen perfektioniert. Denn bisher war es bei dieser Art des Motion Capturings der Fall, dass sogenanntes “Flickering” aufgetreten ist und auch mehrere Kameras benötigt wurden. “Flickering” bezeichnet das Flackern des virtuellen Avatars in den Bewegungen bei der “Pose Estimation”, also der KI gestützten Vorausberechnung der Bewegung. Um das zu verhindern, wird auf den virtuellen Avatar eine Physiksimulation angewendet, was die Pose Estimation der KI deutlich performanter und akkurater macht, da die prognostizierten Bewegungen gleich mit den physikalischen Einschränkungen virtualisiert werden. Mit NVIDIAs neuer KI-Technologie soll es möglich sein nicht mehr im “klassischen” Sinn Motion Capture zu betreiben sondern wie Kevin Xie, Student an der University of Toronto, beschreibt:

“Existing methods require accurate motion capture data for training, which is costly to obtain. Instead, we propose a framework for training generative models of physically plausible human motion directly from monocular RGB videos, which are much more widely available.” (“Physics-based Human Motion Estimation and Synthesis from Videos” - Kevin Xie, Tingwu Wang, Umar Iqbal, Yunrong Guo, Sanja Fidler, Florian Shkurti, University of Toronto, NVIDIA)

Durch diesen Fortschritt rückt die detailgetreue Echtzeit-Übertragung von jeglicher Form der Bewegung und Mimik in einen virtuellen Avatar lediglich über eine handelsübliche Kamera in greifbare Nähe.

Ich möchte im Folgenden darauf eingehen, wie die Darstellende Kunst bereits mit der Technologie des Motion Capturings umgeht. Was sind die ökonomischen und was sind die künstlerischen Gesichtspunkte, die für eine Verwendung im Theater sprechen?

Anwendungsmöglichkeiten für die Darstellenden Künste

Ökonomische Aspekte

Da vor der Corona-Krise und teilweise immer noch an deutschen Theatern die Frage “Wollen wir einen Digitaltheaterabend auf die Beine stellen?” mit “Dafür ist leider kein Budget da.” beantwortet wurde, will ich mich in diesem Abschnitt mit den wirtschaftlichen Aspekten hinter Performance Capture beschäftigen. Denn, damit sich das Theater damit beschäftigt, muss es sich auch aus finanzieller Sicht lohnen. Für mich spielen dabei folgende Faktoren eine Rolle:

Nachhaltigkeit:

Die Anschaffungskosten für ein professionelles MoCap System wie es für das Theater Sinn machen würde, können schnell zu hoch werden, um für ein einzelnes Projekt Sinn zu machen. Deshalb muss man überlegen, ob man sich langfristig mit dieser Technologie auseinandersetzen möchte, oder vielleicht mit einem externen Animationsstudio, einer Spielefirma oder ähnliches zusammenarbeiten möchte. In beiden Fällen ersetzt aber die virtuelle Umgebung ein aufwendig herzustellendes Bühnenbild und spart somit an dieser Stelle wiederum Kosten und Ressourcen ein.

Förderung:

Angesichts der Corona-Krise sind eine Reihe von öffentlichen Fördermöglichkeiten oder Kooperationsmöglichkeiten geschaffen worden, um Kultur trotz Spielverbot auf den Bühnen im digitalen Raum möglich zu machen. Sprich: Überlegt man sich schon Geld in die Hand zu nehmen, um ein Performance Capture Projekt umzusetzen, sollte man sich auch mit den Fördermöglichkeiten auseinandersetzen.

Statistik:

Vergleicht man Zahlen der “Statista”-Analysen aus der Videospielbranche mit Zahlen aus der Kunst- und Kulturbranche, ist gar nicht so eindeutig wohin die Entwicklung geht. Denn die Corona-Pandemie hat gerade für die Theater eine große Umsatzeinbuße bedeutet. Deshalb schaue ich mir die Vor-Corona-Zahlen an:

Mit Gaming wurde 2019 ein Umsatz von ca. 6 Milliarden Euro erzielt (siehe Statista, 2022). Mit Darstellender Kunst tatsächlich genauso viel. Erst durch Corona ist der Umsatz der Theater auf ca. 2 Milliarden Euro geschrumpft und der Umsatz der Gaming Branche auf ein Hoch von 10 Milliarden Euro gestiegen. Die weitere Entwicklung bleibt abzuwarten, dennoch zeigen die Daten vor 2019 klar, dass die Gaming Branche aus wirtschaftlicher Sicht einen genauso wichtigen Posten für Deutschland einnimmt, wie die Darstellende Kunst und daher auch im Hinblick auf die Konsumenten der Zukunft betrachtet werden muss, wohin diese Entwicklung geht.

Die Zahl der Besuche im Theater bleibt seit 10 Jahren gleichbleibend bei ca. 20 Millionen Besuchen. Im Gaming-Bereich waren die Zahlen der deutschlandweiten Videospieler*innen der letzten zehn Jahre aber auch gleichbleibend bei ca. 34 Millionen Personen.

Durch die Corona-Pandemie hat sich hier die Entwicklung aber potenziert und seit 2021 greifen 6 von 10 Personen (59 Prozent) im Alter von 6 bis 69 Jahren zu PC-, Konsolen- oder Mobile Spielen. (Verband der deutschen Games-Branche, 2022)

Es geht mir mit dieser kleinen Marktanalyse nicht darum zu zeigen, welche Branche mehr Daseinsberechtigung hat. Wenn aber mittlerweile tatsächlich 6 von 10 Personen Videospiele konsumieren, dann sollte man sich auch anschauen, aus welchen Gründen sie das tun. Deshalb lohnt es sich auch im Hinblick auf die Entwicklung der Zuschauer, sich mit dem Thema Performance Capture und den daraus ergebenden Interaktionsmöglichkeiten für das Theater zu beschäftigen.

Förderung digitaler Projekte in Kunst und Kultur Deutschland:

Kulturstiftung des Bundes - Fonds Digital “Das Programm Kultur Digital will Kultureinrichtungen motivieren und sie darin unterstützen, die digitalen Möglichkeiten und Herausforderungen der Gegenwart [...] mitzugestalten [...] .” www.kulturstiftung-des-bundes.de/de/projekte/film_und_neue_medien/detail/kultur_digital.html

Initiative Kultur- und Kreativwirtschaft - Kreativpilot*innen Deutschland “Seit 12 Jahren zeichnet die Bundesregierung jährlich 32 Unternehmen der Kultur- und Kreativwirtschaft und ihren Schnittstellen zu anderen Branchen aus.” www.kultur-kreativpiloten.de/

Staatsministerin für Kultur und Medien - NEUSTART KULTUR-Digital-Programme:

KULTUR.GEMEINSCHAFTEN “[...] Die Kulturstaatsministerin und die Kulturstiftung der Länder fördern insbesondere kleinere, auch ehrenamtlich geführte Kultureinrichtungen und Projektträger [...] bei der Entwicklung digitaler Angebote mit insgesamt bis zu 22 Millionen Euro.”

Dive in. Programm für digitale Interaktionen “Die Kulturstiftung des Bundes hat mit „dive in“ ein Programm für digitale Interaktionen aufgelegt. [...] Gefördert werden digitale Projekte, die neue Formen der Wissensvermittlung und künstlerischen Auseinandersetzung, der spielerischen Aneignung oder der Partizipation mit Besucherinnen und Besuchern erproben.” www.bundesregierung.de/breg-de/bundesregierung/bundeskanzleramt/staatsministerin-fuer-kultur-und-medien/digital-programme-1777048

Künstlerische Aspekte

Was hat das Theater als “klassische” Institution der Darstellenden Künste also auf künstlerischer Ebene davon sich mit Performance Capture zu beschäftigen? Dieser Frage möchte ich mit zwei Beispielen der “Royal Shakespeare Company” aus London nachgehen.

Eines der frühesten Beispiele für Realtime Performance Capture im Theater ist die Inszenierung “The Tempest” der “Royal Shakespeare Company” in London aus dem Jahr 2016. Sie ist als eine Koproduktion der RSC, Intel und “The Imaginarium Studios”, einem Motion Capture Studio aus London, entstanden. In dieser Inszenierung wird die Rolle des “Ariel”, ein Luftgeist, mit den mitteln des Performance Capturings von dem Schauspieler Mark Quartley performt und live als Avatar auf die Bühnenfläche projiziert. Dadurch kann “Ariel”, der Luftgeist, tatsächlich über die Bühne fliegen und digital in verschiedene Avatare gemorpht werden und trotzdem sieht die Performance, im Sinne der Einmaligkeit des Theaterabends, bei jeder Vorstellung anders aus, da alles in Echtzeit ohne Nachbearbeitung geschieht.

Ein aktuelleres Beispiel der “Royal Shakespeare Company” dafür wie sich Performance Capture auch im XR-Bereich, sprich Extended Reality, also sowohl AR (Augmented Reality) als auch VR (Virtual Reality), umsetzen lässt, ist die Inszenierung “Dream”, die im März 2021 Premiere feierte. Hier wird nicht nur das Ergebnis des Performance Capturings live auf die Bühne projiziert, sondern das ganze in eine virtuelle Umgebung gepackt, sodass das Publikum das live gespielte Ergebnis von Zuhause aus am Computer, Handy oder einem anderen internetfähigen Gerät verfolgen und sogar damit interagieren kann.

Um das möglich zu machen, haben die “Royal Shakespeare Company”, “Marshmallow Lase” Feast, ein Künstler-Techniker-Kollektiv aus London und das “Philharmonia Orchestra London” zusammengearbeitet. Im Rahmen des Projekts “Audience of the Future Demonstrator”, unterstützt vom “Government Industrial Strategy Challenge Fund” der britischen Regierung, ist dieses Projekt entstanden, um auf den Erfahrungen der bereits erwähnten Inszenierung “The Tempest” von 2016 aufzubauen und, durch die Corona-Krise bedingt, ein Theatererlebnis für die Zuschauer zuhause zu ermöglichen.

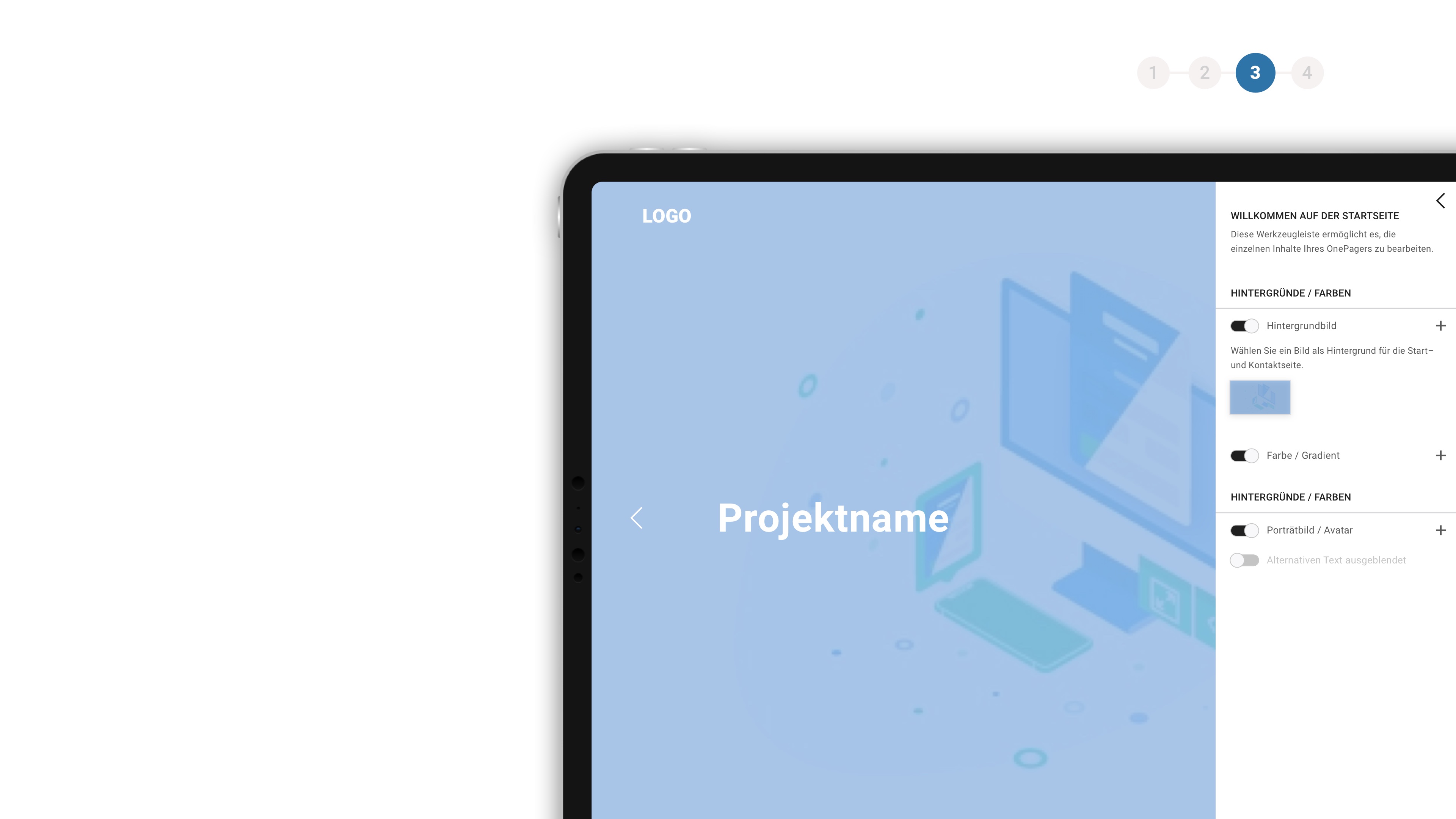

Hierzu wurde ein 7x7 Meter “Motion-Capture-Volume” gebaut, also der Raum zur Aufzeichnung der Bewegungsdaten, in dem die Darsteller*innen spielen und mit einem LED-Hintergrund ergänzt, der den Darstellern live ihre Performance widerspiegelt, wie in Abbildung 9 zu sehen ist.

Es werden aktuellste Vicon-Kameras in Verbindung mit Facial Rigging eingesetzt, um die komplette Performance der Darsteller*innen einzufangen und mit der “Unreal Engine 4” live in die virtuelle Welt einzubauen. Dort können die Darsteller durch Bewegung ein auf ihre Avatare reagierendes Musiksystem beeinflussen. Die Zuschauer können an ihren Endgeräten über Input via Maus oder Touchpad den Darsteller*innen zum Beispiel die Richtung weisen.

Die Arbeit der Royal Shakespeare Company stellt für mich damit ein Paradebeispiel für die erfolgreiche Umsetzung von Performance Capture Technologie im Theater dar. Die Arbeit ist wegweisend dafür, was mit der Performance Capture Technologie bereits möglich ist und in Zukunft möglich sein wird.

Fazit

Um die Frage danach zu beantworten, was das Theater auf künstlerischer Ebene davon hat, sich mit Performance Capture auseinanderzusetzen, möchte ich weiter auf den Aspekt der Immersion und der Interaktionsmöglichkeit eingehen. Denn normalerweise stellt man sich unter Theater das “klassische” Zuschauer-Darsteller-Verhältnis vor, in dem wenig bis gar keine Interaktion zwischen dem Geschehen auf der Bühne und den Zuschauern stattfindet. Durch Interaktionsmöglichkeiten wie bei der Inszenierung “Dream”, werden die Zuschauer aktiver Teil des Geschehens auf der Bühne oder im virtuellen Raum. Dadurch entsteht Immersion, also das Eintauchen des Zuschauers in eine andere Realität. Immersion und Interaktion sind damit die Key-Features von Inszenierungen auf Basis von Performance Capture und unterscheiden sie damit auch von der “klassischen” Theaterkultur des reinen Konsumierens.

Aus diesem Grund sollte sich Theater aus künstlerischer Sicht mit dieser Technologie auseinandersetzen. Videospiele entwickeln einen immer größeren Einfluss darauf, wie wir moderne Medien konsumieren möchten und der Aspekt der Immersion wird auch hier immer größer geschrieben. Es ist einer der wichtigsten Gründe, warum Konsumenten Videospiele kaufen: Das Abtauchen in eine andere Realität - letztendlich will Theater genau das selbe, egal ob immersiv oder passiv. Beides hat seine Berechtigung, aber im Sinne der Weiterentwicklung hin zu “Darstellender Kunst 4.0” finde ich es wichtig, am Aspekt der Immersion weiterzuforschen. Passives, “klassisches” Theater gibt es immerhin schon seit der Antike.

Über den Autor

Quellenangaben und weiterführende Informationen

Literatur:

Vicon. (2021). VFX and motion capture technology: A 2025 vision paper. USA & UK: Vicon, Denver, LA, Oxford.

Prof. Vladlen Koltun. ‘Motion Capture’, Paper. Stanford University, zuletzt abgerufen am: 22.06.2022, http://graphics.stanford.edu/

Kitagawa, Midori, Windsor, Brian. (2020). MoCap for Artists: Workflow and Techniques for Motion Capture. London & New York: Taylor & Francis.

Rueß, Christoph. (2019). Vergleich zwischen Pose to Pose und Motion Capture für die Erstellung zweidimensionaler Walk Cycles. Gießen-Friedberg: Fachhochschule Gießen-Friedberg.

David, Antonio (2011). ‘3D motion capture by computer vision and virtual rendering’, Doktorarbeit. Paris: Télécom SudParis.

Weisel, Christian. (2004). Entwicklung eines markerbasierten Motion Capturing-Systems für Echtzeitanwendungen. Gießen-Friedberg: Fachhochschule Gießen-Friedberg.

Horrocks, Nathan. (2021) ‘NVIDIA Research: Generating Motion Capture Animation Without Hardware or Motion Data’, NVIDIA, 15.12.2021, zuletzt abgerufen am: 22.06.2022, https://developer.nvidia.com/

Summers, N., engadget.com (2017) ‘The real-time motion capture behind ‘Hellblade’’, zuletzt abgerufen am: 22.06.2022, https://www.engadget.com/

Wiesseckel T. , entwickler.de (2016) ‘Motion Capturing hinter den Kulissen’, zuletzt abgerufen am: 07.02.2022, https://entwickler.de/programmierung/motion-capturing-hinter-den-kulissen/

Akademie für Theater und Digitalität am Theater Dortmund (2022) ‘Akademie Wiki 0.2 (Alpha)’, zuletzt abgerufen am: 07.02.2022, https://wiki.theater.digital/

Diesselhorst S., nachtkritik.de (2021) ‘Mit einer URL in die digitale Zauberwelt’, zuletzt abgerufen am: 07.02.2022, https://www.nachtkritik.de

Law N., UCF University Of Central Florida (2020) ‘Motion Capture to On-screen Acting: Theatre, Animation and Film Programs Team Up’, zuletzt abgerufen am: 07.02.2022, https://www.ucf.edu/

Quantic Dream, youtube.de (2020) ‘Detroit: Become Human – Performance Capture’, zuletzt abgerufen am 07.02.2022, https://www.youtube.com/

Seymour, M., fxguide.com (2016), ‘Put your (digital) game face on’, zuletzt abgerufen am: 22.06.2022, https://www.fxguide.com/

Seymour, M., fxguide.com (2016), ‘Quantic Dream becomes human’, zuletzt abgerufen am: 22.06.2022, https://www.fxguide.com/

Hurst, A., digitalmediaworld.tv (2016), ‘Mocap Innovation Captures the Spirit of Ariel in ‘The Tempest’, zuletzt abgerufen am: 22.06.2022, https://www.digitalmediaworld.tv/

Maier, F., www.orpheus-magazin.de (2022), ‘Eindrücke vom 1. Forum für Theater und digitale Transformation’, zuletzt abgerufen am: 22.06.2022, https://www.orpheus-magazin.de/

Royal Shakespeare Company, rsc.org.uk (2021), ‘LIVE PERFORMANCE AND GAMING TECHNOLOGY COME TOGETHER TO EXPLORE THE FUTURE FOR AUDIENCES AND LIVE THEATRE’, zuletzt abgerufen am: 22.06.2022, https://www.rsc.org.uk/

game Verband der deutschen Gamesbranche, www.game.de (2022), ‘Zahl der Gamerinnen und Gamer in Deutschland wächst weiter’ zuletzt abgerufen am: 22.06.2022, https://www.game.de/

statista Datenbank, de.statista.com (2022), ‘Umsatz im Gaming-Markt von 2012 bis 2021’, ‘Umsatzentwicklung im Markt für darstellende Künste in Deutschland von 2003 bis 2020’, zuletzt abgerufen am: 22.06.2022, https://de.statista.com/

Kulturstiftung des Bundes, kulturstiftung-des-bundes.de (2022), ‘Fonds Digital - Für den digitalen Wandel in Kulturinstitutionen’, zuletzt abgerufen am: 22.06.2022, https://www.kulturstiftung-des-bundes.de/

Kultur- und Kreativpilot*innen Deutschland, kultur-kreativpiloten.de (2022), zuletzt abgerufen am: 22.06.2022, https://kultur-kreativpiloten.de/

Staatsministerin für Kultur und Medien, bundesregierung.de (2022), ‘NEUSTART KULTUR Digital-Programme’, zuletzt abgerufen am: 22.06.2022, https://www.bundesregierung.de/

Abbildungen:

Titelbilder (v.l.n.r.: ©Ninja Theory, ©Quantic Dream, ©Royal Shakespeare Company, ©Akademie für Theater und Digitalität)

Akademie für Theater und Digitales (2021) Abb.1: Workspace der Akademie für Theater und Digitalität, Marcus Lobbes, Dortmund, zuletzt abgerufen am: 30.06.2022, https: //ne-np.facebook.com/theater.digital/photos/883709135672763/

Die Augsburger Zeitung (2021) Abb.2: Erste deutsche Digitaltheater-Sparte, Staatstheater Augsburg, Augsburg, zuletzt abgerufen am: 30.06.2022, https://www.daz-augsburg.de/staatstheater-augsburg- ein-interessanter-spielplan-auf-den-man-sich-freuen-darf/

Weisel, C. (2004) Abb.3: Vereinfachter Ablauf eines markerbasierten Motion Capture Vorgangs, Fachhochschule Gießen-Friedberg, Gießen-Friedberg, zuletzt abgerufen am: 30.06.2022, http://digdok.bib.thm.de/volltexte/2005/3321/pdf/diplomarbeit.pdf

Max Planck Institute For Intelligent Systems Tübingen (2021) Abb.4: Optisches MoCap-System, MPIIS, Tübingen, zuletzt abgerufen am: 30.06.2022, https://ps.is.mpg.de/uploads/ckeditor/pictures/ 1628/content_20210928_MPIIS_Tuebingen_175.jpg

Prof. Vladlen Koltun (Unbekannt) Abb.5: Elektromagnetischer MoCap-Suit, Stanford University, Stanford, zuletzt abgerufen am: 22.06.2022 http://graphics.stanford.edu/courses/cs448-09-spring/ motion_capture.pdf

Meta Motion (2004) Abb.6: “Gypsy 6”, ein mechanisches MoCap-Exoskelett, Meta Motion, Unbekannt, zuletzt abgerufen am: 22.06.2022 https://metamotion.com /gypsy/old/gypsy-torso.htm

20th Century FOX (2019) Abb.7: “Alita Battle Angel” Behind the Scenes, Youtube 20th Century Studios zuletzt abgerufen am: 22.06.2022 https://www.youtube.com/watch?v=hOMuRopLgxg

Ninja Theory (2017) Abb.8: “Hellblade: Diary 21 - Making a Virtual Human | Real-time performance capture”, Youtube Ninja Theory zuletzt abgerufen am: 22.06.2022 https://www.youtube.com/ watch?v=CmrXK4fNOEo

Martin, S. Royal Shakespeare Company (2021) Abb.9: “Dream”-Inszenierung der Royal Shakespeare Company, Making-Of, RSC, London, zuletzt abgerufen am: 22.06.2022 https://www.orpheus -magazin.de/2022/02/28/unendliche-weiten/

Kommentare

Es wurde noch keine Kommentare eingestellt